中国教育在线讯 在机器学习中,你是否为辛苦建立的深度学习模型精度不够而苦恼?是否为了提高性能推倒原有结构重新训练而耗费心力?日前,由华南理工大学陈俊龙教授及其团队设计的一种可以动态扩展神经元及其层数的颠覆性深度和宽度结合,且不用从头开始的动态结构神经网络——叠层宽度学习网络(Stacked BLS),将使这些困难迎刃而解!

众所周知,深度神经网络学习结构输入层与输出层节点固定,整个网络的结构也随之固定。2018年 “图灵奖”的获得者Geoffrey Hinton等3位教授的一项重要贡献——基于梯度下降的反向传播算法,也是基于固定的深度神经网络架构,通过参数调整探索数据内部的深层表征。这种类型的深度神经网络已经在许多领域得到应用,尤其是在大规模数据处理上取得了突破性的成功。但是其训练过程耗费巨大的算力与时长,是困扰学术界40余年的问题。

陈俊龙教授提出的Stacked BLS的结构,通过单层结构和求伪逆的方法,通过叠层的思想,可以灵活地改变网络结构的宽度和深度,获得模型最优解。因此,能够针对不同任务进行动态的调整,提高模型的灵活性、适应性和泛化能力。同时节省了大量的计算资源,并大幅缩短计算时长。该系统在实际应用中,赋予边缘端智能学习功能的边缘计算无限的前景。

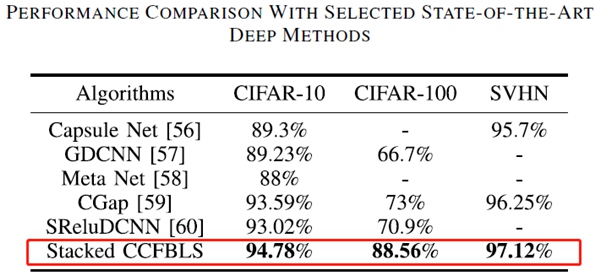

分类准确率优于现有多种方法的比较

以典型图像分类数据集CIFAR-10、CIFAR-100为例,与深度残差网络等基础模型相比,该系统大幅降低了网络计算时所需要的参数数量,参数量为其1/8至1/4。

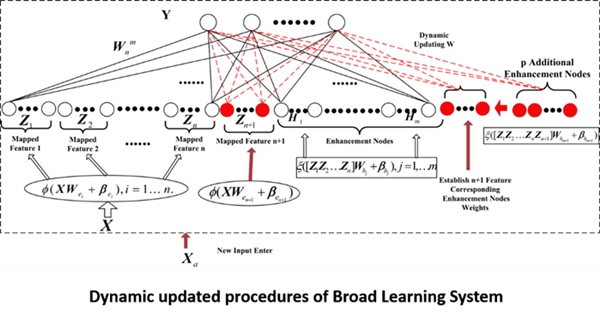

陈俊龙教授团队的这一成果,是在其2018年提出了宽度学习系统(Broad Learning System,BLS;此2018年论文也获2021年IEEE Transactions on Neural Networks and Learning Systems年度最佳期刊论文)的基础上提出的。

宽度学习系统动态网络结构示意图

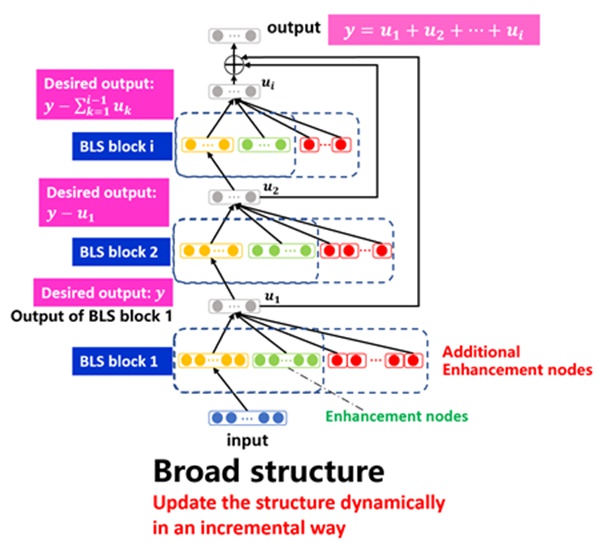

通过构建叠层宽度神经网络成深度模型,在IEEE Transactions on Systems, Man, and Cybernetics: Systems会刊以“Stacked Broad Learning System: From Incremental Flatted Structure to Deep Model”为题发表。Stacked BLS模型通过残差连接将多个BLS模块叠加起来,增加了网络的深度,提高了网络的学习能力,同时在每个模块中沿用了BLS基本训练算法,从而能保留BLS高效、快速的优点。

叠层宽度学习网络(Stacked BLS)模型示意图

Stacked BLS的“动态”体现在宽度和深度两个方向的增量学习。这两种增量学习的方式可以大大减少模型的计算量,并实现快速、高效的训练,降低网络复杂性。

据了解,陈俊龙教授及其带领的数据科学与人工智能实验室研究团队在类脑智能、智能计算与智能系统、混合智能、数据科学领域,以及围绕高性能计算、深度学习和宽度学习算法及其在情感计算、系统优化等研究方向取得了一系列的创新性科研成果。

中国教育在线 林剑 通讯员 张通

① 凡本站注明“稿件来源:中国教育在线”的所有文字、图片和音视频稿件,版权均属本网所有,任何媒体、网站或个人未经本网协议授权不得转载、链接、转贴或以其他方式复制发表。已经本站协议授权的媒体、网站,在下载使用时必须注明“稿件来源:中国教育在线”,违者本站将依法追究责任。

② 本站注明稿件来源为其他媒体的文/图等稿件均为转载稿,本站转载出于非商业性的教育和科研之目的,并不意味着赞同其观点或证实其内容的真实性。如转载稿涉及版权等问题,请作者在两周内速来电或来函联系。

中国教育在线

中国教育在线